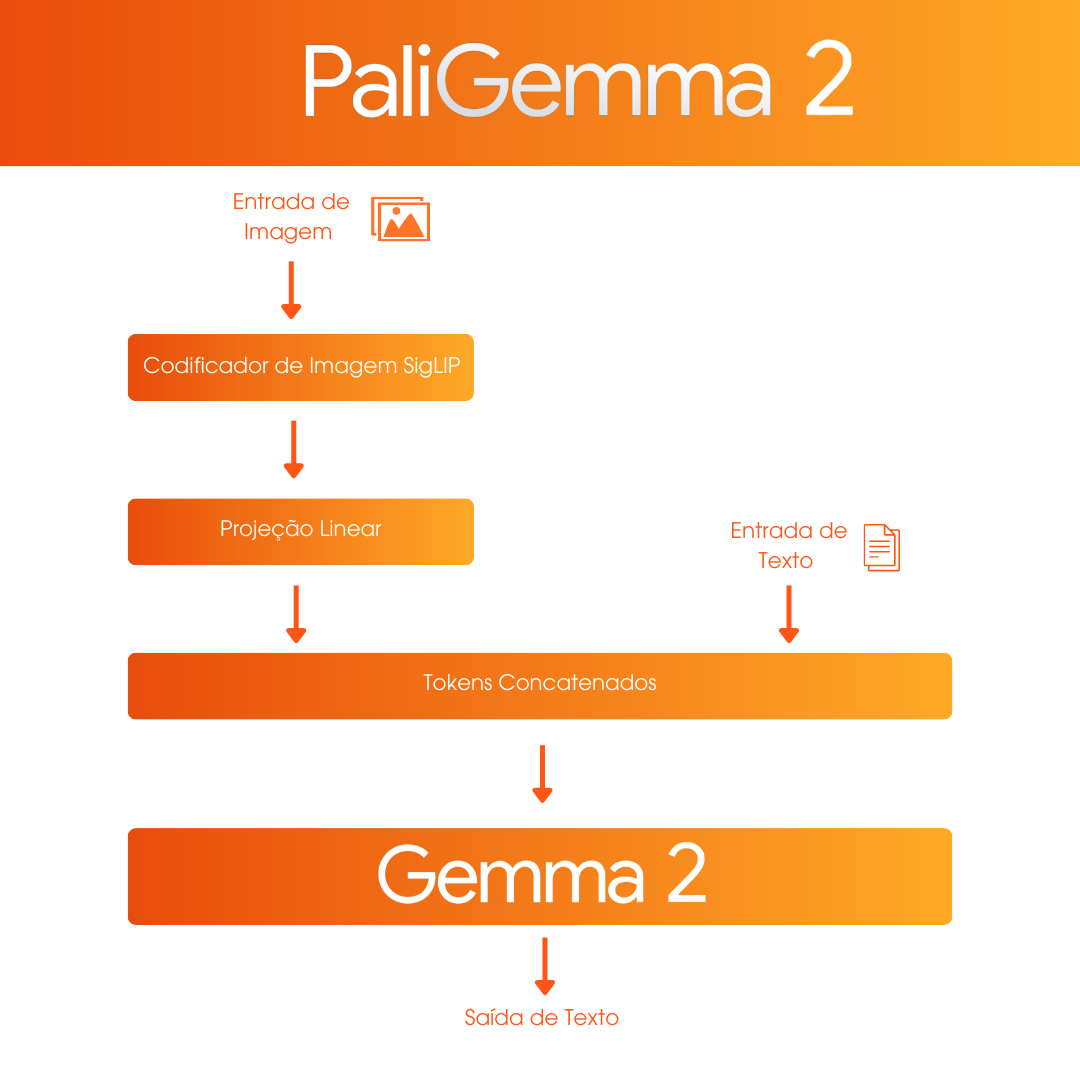

PaliGemma 2: uma nova IA de visão-linguagem

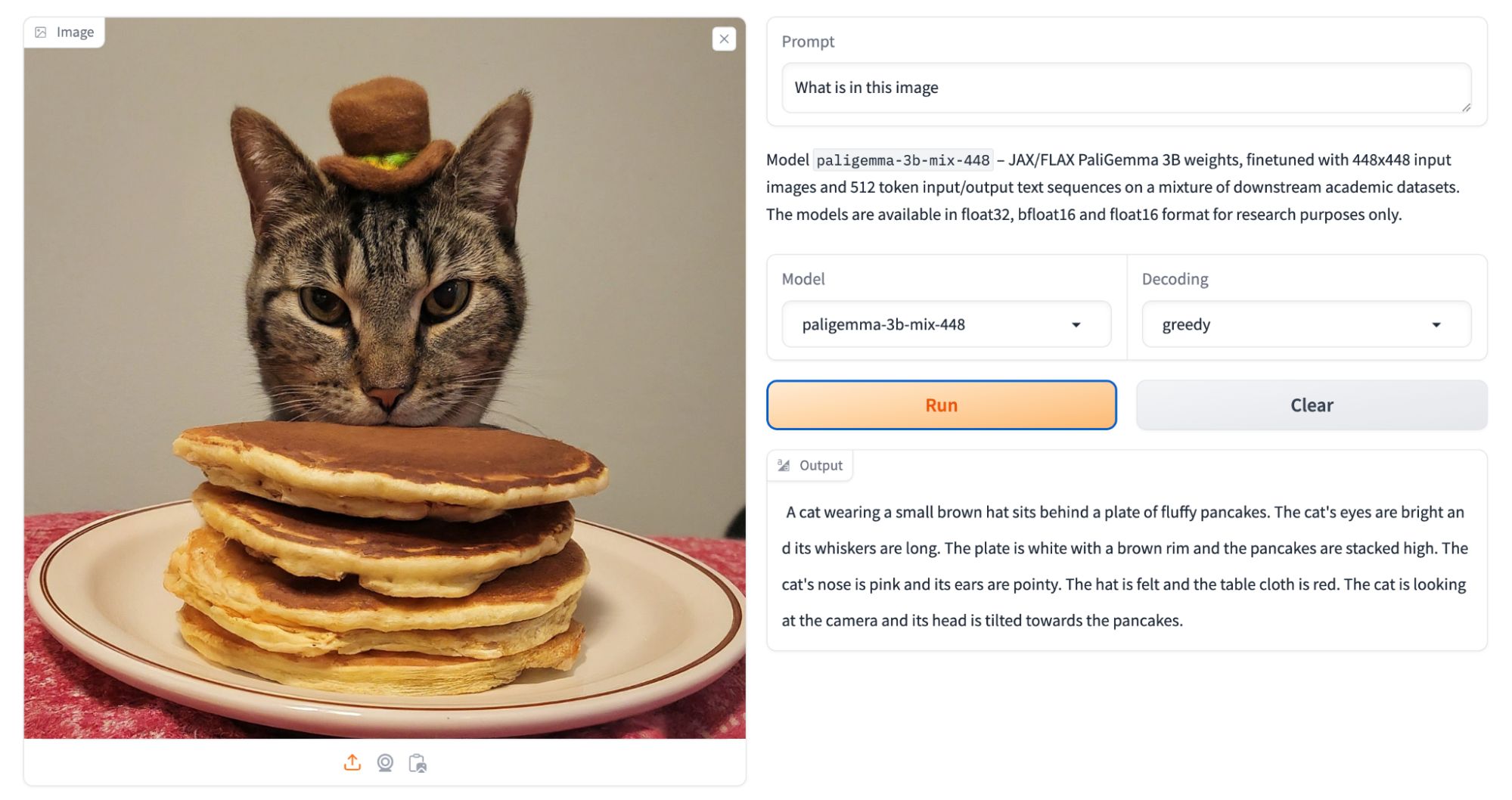

O PaliGemma 2, lançado na última semana pela Google, é um grande avanço na área de modelos de visão-linguagem (VLM). Ele é capaz de interpretar imagens com precisão, realizar tarefas como geração de legendas, resposta a perguntas visuais e análise de textos em imagens (OCR). Suas aplicações incluem reconhecimento de objetos, segmentação e geração de respostas baseadas no conteúdo visual. Uma característica curiosa é a capacidade de “identificar” emoções.

Este modelo, integrante da família Gemma, está disponível em diferentes configurações, com opções de 3, 10 e 28 bilhões de parâmetros. Essas variações permitem atender a uma ampla gama de demandas, desde análises de imagens em baixa resolução (224px) até aplicações avançadas em resoluções de 896px. Essa versatilidade viabiliza sua adaptação a diversos cenários.

Embora a interpretação de emoções seja um recurso do modelo, especialistas apontam que essa tarefa ainda é subjetiva e enfrenta desafios éticos. A Google afirma que extensos testes foram conduzidos para mitigar vieses demográficos e reduzir a "toxicidade", garantindo que os resultados estejam alinhados aos padrões mais avançados do mercado.

Como sabemos, a visão computacional vem auxiliando as operações em diversos setores, desde análise de qualidade em linhas de produção até gestão de inventários. Modelos como o PaliGemma 2 ampliam essas possibilidades, oferecendo novos níveis de automação e interpretação de dados visuais.

Você já considerou como essas tecnologias podem otimizar as suas operações?